ذاكرة ChatGPT الدائمة.. ابتكار يثير جدل الخصوصية والاعتماد

شات جي بي تي

ياسين عبد العزيز

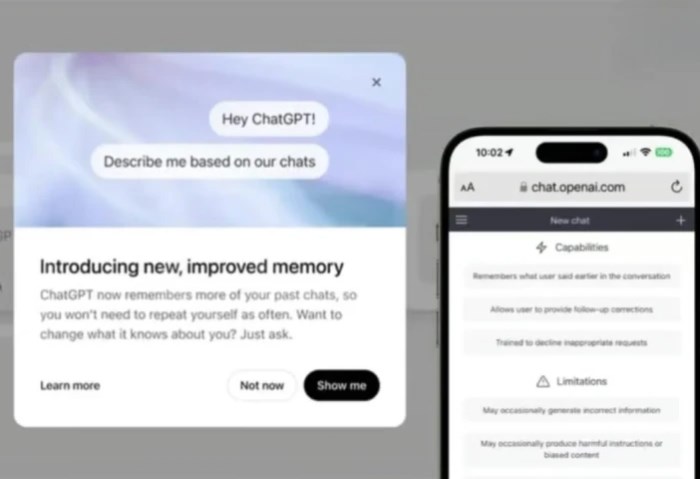

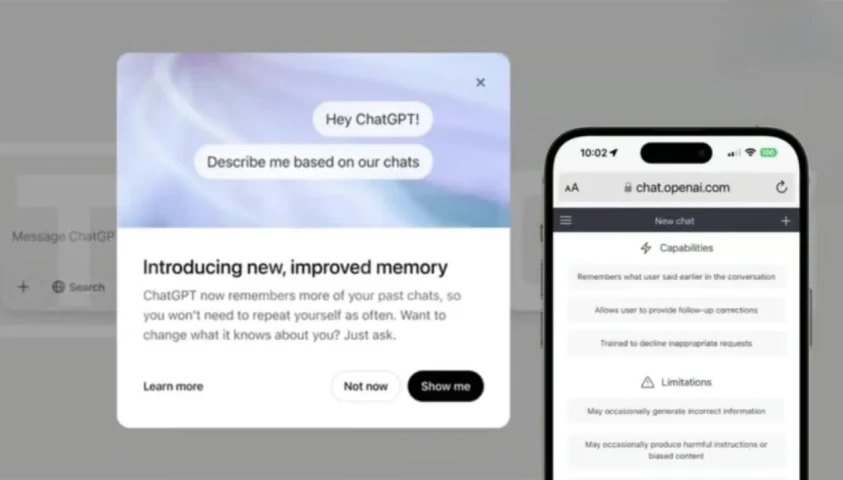

أعلنت شركة OpenAI عن تفعيل خاصية "الذاكرة الدائمة" في نموذج ChatGPT، وهي خطوة جديدة تعزز من قدرات الذكاء الاصطناعي على تذكر معلومات المستخدمين وتخصيص التفاعل معهم بناءً على محادثاتهم السابقة.

وتتوفر هذه الخاصية حاليًا لمشتركي خطتي ChatGPT Plus وPro، حيث تهدف إلى تقليل الحاجة لإعادة شرح نفس التفاصيل في كل تفاعل، وتقديم تجربة استخدام تتكيف مع أسلوب المستخدم واهتماماته.

تجربة مخصصة

تعتمد خاصية الذاكرة الدائمة على حفظ تفاصيل مثل طريقة الكتابة، والأهداف الشخصية، وحتى التفضيلات الخاصة، مثلًا، إذا ذكرت رغبتك باتباع نظام غذائي صحي، فإن ChatGPT سيتجنب اقتراح خيارات غير مناسبة مثل الوجبات السريعة، وإذا كنت من محبي أفلام الخيال العلمي، فسيظهر ذلك في ترشيحاته.

ويرى روهان سارين، المتخصص في الذكاء الاصطناعي، أن هذه الميزة تعزز التفاعل الطبيعي، حيث أن "التخصيص يرتكز على الذاكرة"، ومع الوقت، يمكن أن يشعر المستخدم بأن الذكاء الاصطناعي "يعرفه" بالفعل، مما يعزز الارتباط العاطفي بين الطرفين ويجعل استخدامه أكثر سلاسة.

عواقب التخصيص

لكن هذه القدرة على التخصيص تأتي بثمن، فمع تخزين كل هذه المعلومات، تزداد احتمالية أن يُعيد ChatGPT إنتاج صورة قديمة عن المستخدم، مثلًا، إذا أبدى المستخدم اهتمامًا سابقًا بموضوع معين ثم غيّر موقفه لاحقًا، قد يستمر النظام في تقديم محتوى يتماشى مع التفضيل القديم.

وهذا ما يثير القلق حول تشكيل هوية المستخدم بناءً على بيانات غير محدثة، فالبشر بطبيعتهم ينسون ويتجاوزون، لكن الذكاء الاصطناعي لا يفعل، مما يعني أن النظام قد يُقيد تطور المستخدم من خلال استحضار ذكريات لم يعد يرغب بالارتباط بها.

تحديات الخصوصية

في البيئات المهنية، تساهم الذاكرة الدائمة في تسريع العمل وتقليل التكرار، لكن بالمقابل تطرح مخاطر تتعلق بسرية البيانات.

ويحذر جوليان ويفن، خبير في ذكاء الأعمال، من خطر تسرب معلومات حساسة بين المشاريع أو تخزين معلومات تجريبية تم استخدامها لمرة واحدة فقط.

وحتى مع وجود خيارات مثل "الدردشة المؤقتة" أو إمكانية حذف الذاكرة يدويًا، يبقى الغموض قائمًا حول ما يتم تخزينه فعلًا، وكم من الوقت تبقى البيانات محفوظة.

ويضيف ويفن أن الالتزام بالتشريعات الأوروبية مثل قانون GDPR يصبح معقدًا مع أنظمة تعتمد على ذاكرة غير شفافة، ويؤكد على ضرورة وجود "حواجز حماية وتحكم صارم"، خاصةً في القطاعات الحساسة كالرعاية الصحية والخدمات المالية.

استراتيجيات متباينة

مقارنة ببعض المنصات الأخرى، فإن OpenAI اختارت توسيع نطاق الذاكرة الدائمة لتعزيز التخصيص، في حين أن منصات مثل Claude لا تحتفظ بأي معلومات بعد انتهاء الجلسة، مما يوفر حماية أقوى للخصوصية لكن على حساب التجربة الشخصية.

من ناحية أخرى، يتبنى محرك Perplexity استراتيجية تعتمد على البحث اللحظي دون ذاكرة سابقة، أما Replika فيخزن مشاعر المستخدمين لبناء علاقة رقمية طويلة الأمد، هذا التباين يعكس غياب اتفاق على النموذج الأمثل لإدارة العلاقة بين الذكاء الاصطناعي والبيانات الشخصية.

إشكالية الاعتماد

الذاكرة الدائمة في ChatGPT ليست فقط أداة لتحسين الخدمة، بل هي جزء من نموذج أعمال أوسع يسعى إلى زيادة الاعتماد على النظام من خلال تخصيص التفاعل بشكل جذاب وعملي.

لكن مع هذا التخصيص، يطرح سؤال أساسي: إلى أي مدى نريد أن نمنح الذكاء الاصطناعي حق تذكر تفاصيل حياتنا؟ وما هي الحدود التي يجب أن نرسمها لمنع تحول الأداة إلى مرآة ثابتة لا تعكس إلا نسخًا قديمة منا؟

أخبار ذات صلة

أحدث الموبايلات

-

Apple iPhone 13 Pro Max

-

Xiaomi Redmi Note 11

-

Samsung Galaxy A52s

-

OPPO Reno6 Pro 5G

-

realme GT2 Pro

-

vivo Y19

-

Honor 50 Pro

-

Huawei Nova 9

-

Nokia 8.3 5G

هل يتراجع عدد عملاء CIB خلال الفترة المقبلة بعد زيادة أسعار رسوم التحويل والخدمات؟

-

نعم

-

لا

-

غير مهتم

أكثر الكلمات انتشاراً